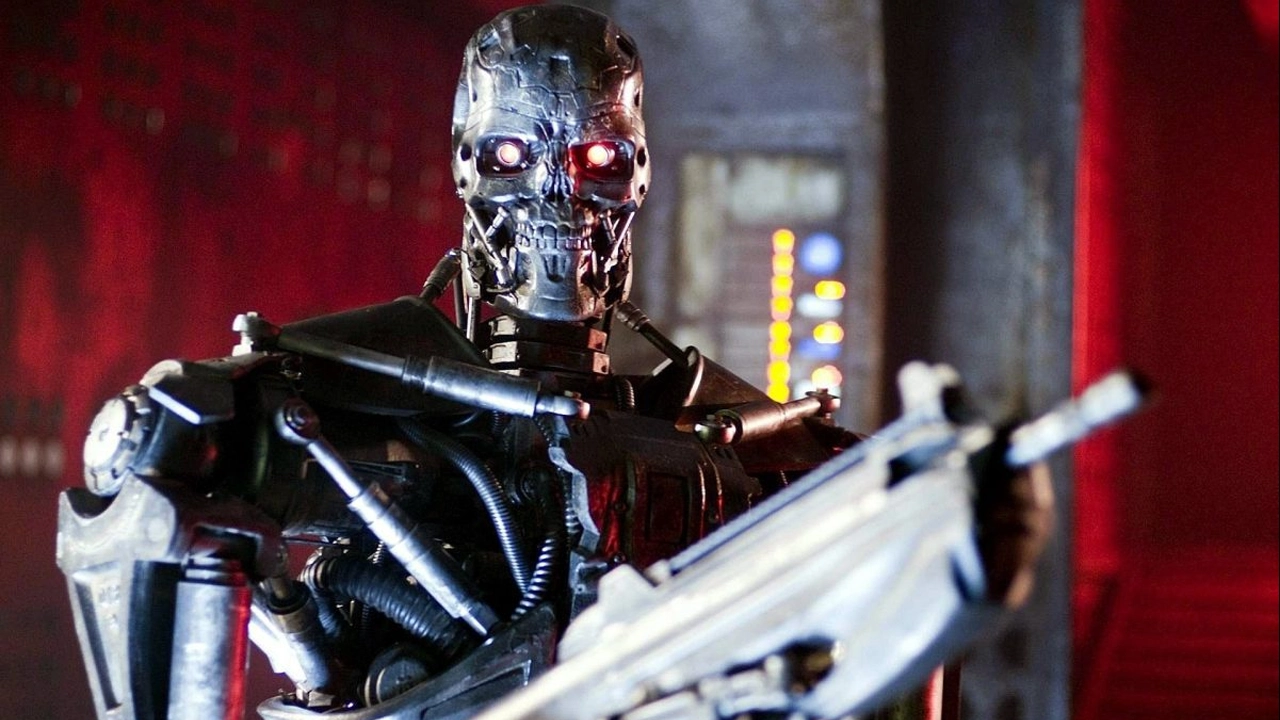

- Her geçen gün savaşlarda otonom silah sistemleri daha fazla kullanılıyor.

- Birleşmiş Milletler "katil robotlar" tehlikesinin artan kullanımı nedeniyle uluslararası düzenleme ihtiyacını gündeme taşıdı.

- Bu tür yapay zeka destekli silahlarla alakalı ciddi etik ve güvenlik endişeleri değerlendiriliyor.

Birleşmiş Milletler (BM), yapay zekayla çalışan otonom silahlar olan Ukrayna ve Gazze Şeridi gibi savaşlarda kullanımı giderek artan sözde katil robotların düzenlenmesine yönelik acil ihtiyacı görüşmek üzere New York’taki merkezinde toplandı.

Net ve bağlayıcı kuralların olmaması uzmanları ve insan hakları örgütlerini endişelendiriyor. Yapılan toplantı, BM Genel Kurulu’nun konuya özel olarak ayrılmış ilk oturumu olacak. Bağlayıcı olmasa da uluslararası bir antlaşmanın kabulüne direnen ABD, Çin ve Rusya gibi askeri güçler üzerinde diplomatik baskıyı artırmak amaçlanıyor.

ABD, Çin, Rusya ve Hindistan düzenlemeye direniyor

164 ülkenin 2023’te acil eylem çağrısı yapan BM kararını desteklemesine rağmen, bu silahların geliştirilmesinde yer alan bazı kilit ülkeler mevcut uluslararası yasaların yeterli olduğunu savunuyor.

ABD, Çin, Rusya ve Hindistan ise küresel bir anlaşmadan ziyade ulusal düzenlemeleri tercih ettiklerini söylüyor.

Pentagon’a göre otonom silahlar, konvansiyonel silahlara kıyasla siviller açısından daha az risk oluşturabilir. Çin, Rusya ve Hindistan hükümetleri henüz Reuters’ın yorum taleplerine yanıt vermedi.

Savaşlarda otonom silahlar çoğalıyor

Diplomatik tartışmalar sürerken, savaş meydanında otonom silahlar çoğalıyor. Future of Life Enstitüsü’ne göre bu tür sistemlerin 200’den fazlası Ukrayna, Ortadoğu ve Afrika’daki çatışmalarda kullanıldı.

Örneğin Rusya, hedefleri otonom olarak tespit edip saldırabilen yaklaşık 3.000 adet Veter kamikaze İHA kullandı. İsrail’in Cenevre’deki ofisinden yapılan açıklamaya göre İsrail Gazze Şeridi’ndeki hedefleri tespit etmek için yapay zeka tabanlı sistemler kullanıyor.

Ukrayna da yarı otonom insansız hava araçları kullanıyor. Fakat yerel yönetim bunların kullanımına ilişkin ayrıntılar hakkında yorum yapmaktan kaçınıyor.

Uzmanlardan kritik uyarı geldi

Uluslararası düzenlemenin eksikliği silahsızlanma uzmanlarını endişelendiriyor. Avusturya Silah Kontrol Şefi Alexander Kmentt felaket senaryolarından kaçınmak için “zamanın tükenmekte olduğu” uyarısında bulundu.

Kmentt, Reuters’a vermiş olduğu demeçte “Teknolojinin onu kontrol etme yeteneğimizi geride bırakmasından önce net yasal engellere ihtiyacımız var. Risk yakın” dedi.

Uluslararası Af Örgütü acilen küresel bir anlaşmanın oluşturulması çağrısında bulunuyor. Kuruluştaki araştırmacılardan Patrick Wilcken, “Bir makinenin yaşam ve ölüm hakkında kararlar almasına izin verip vermememiz gerektiği konusunda hala tartışmaların olması olağanüstü bir şey” dedi.

İnsan Hakları İzleme Örgütü gibi gruplar, mevcut kural eksikliğinin ülkeler ve şirketler arasında yeni bir silahlanma yarışına yol açabileceği konusunda uyarıyor. Öte yandan otonom robotların işlediği insan hakları ihlallerinin hesabının sorulması hala hukuki açıdan açık bir soru olarak karşımıza çıkıyor.

Stop Killer Robots koalisyonundan Laura Nolan’a göre savunma şirketlerinin kendi kendini düzenlemesine güvenmek ciddi bir risk olacak. Nolan konuya ilişkin şunları söyledi: “Sanayilerin kendilerini düzenlemelerine güvenmiyoruz. Savunma sektörünün farklı olduğuna inanmak için hiçbir neden yok.”

BM Genel Sekreteri Antonio Guterres silahlarda yapay zekanın kullanımına ilişkin net kuralların oluşturulması için 2026 yılına kadar süre tanımıştı. O zamana kadar uzmanlar yasal boşluğun geri dönüşü olmayan sonuçlar doğuracak şekilde istismar edilmeye devam edeceğinden endişe ediyor.